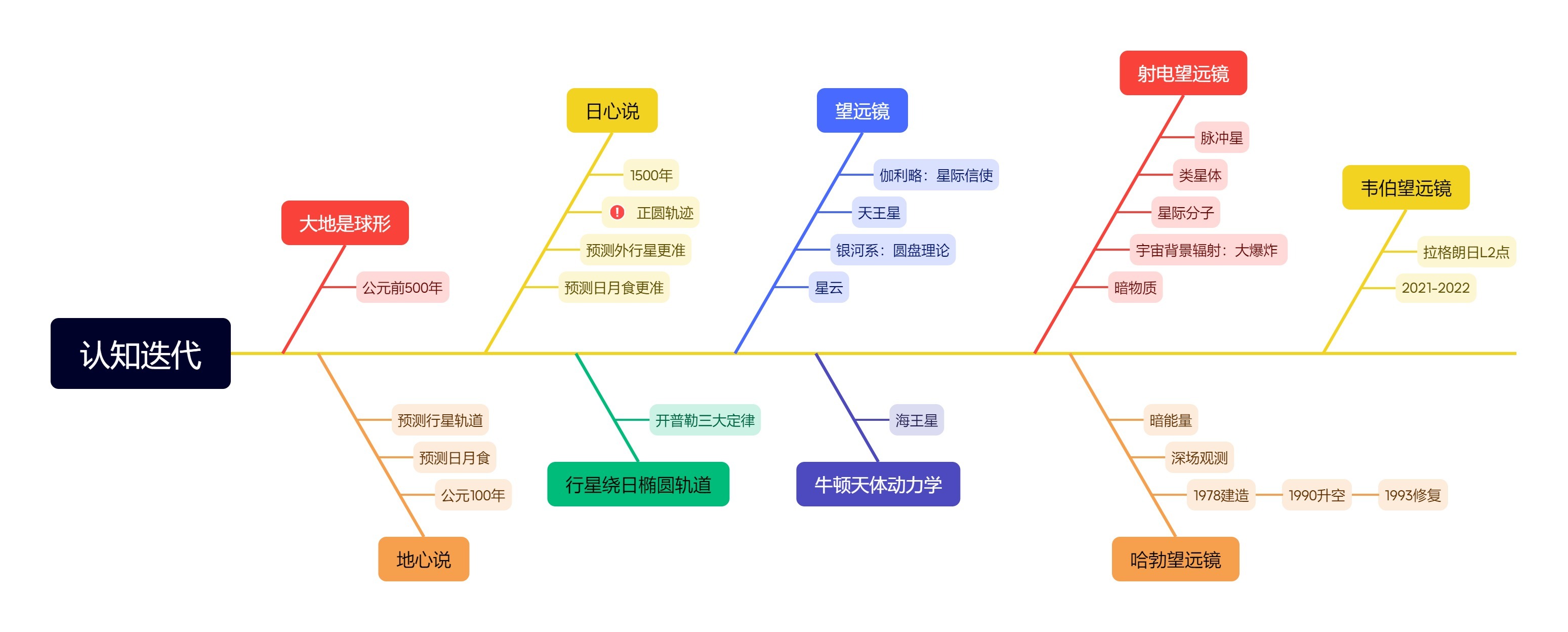

近2周睡前、早起时读完了汪诘《星空的琴弦》一书,很有感触:1、代入到每次认知迭代的时刻,才知道它有多艰难,以及它还有多少缺陷;2、最新的宇宙学认知猜想,比如暗物质、暗能量,也是建立在科学证据上的。

人类宇宙认知观的迭代,主要来自以下9个变化。

大地是圆的

人类科学技术的发展,来源于古希腊文明,天文学也不例外。在公元前500年,毕达哥拉斯就提出了大地是圆的(就是凭直觉任性),当然他只是提出了猜想,无法证明。这位老兄几乎可以称得上是现代科学的奠基人之一,在他之前各文明中的数学就是测量+计算,但他开创了“公理->定理->证明”演绎法,为100年后欧几里得的《几何原理》奠定了基础。而后过了200年,亚里士多德通过船远离时船身先消失、船帆后消失,以及月食现像,证实了大地是圆的。当然,因为还没出现牛顿的万有引力,无法解释下面的人为啥不会掉下去,他只好解释说万物都要向宇宙中心掉落,而地球中心就是宇宙的中心。

地心说

大地是圆形这一认知太反常识了,人类各文明中只有古希腊走出了这一步!有了这一认识,400多年后托勒密才能提出地心说,他可以基于本轮、均轮这套大圆套小圆的圆周运动,通过80多个轮子将日食、月食的预测误差降至1小时以内,五大行星的预测误差降到几天以内。而直到清朝古代中国也没有搞清楚大地是圆的,对于日食的出现皇帝要下罪己诏,搞不好天文观测台的官员还得杀掉几个。所以“天子”这个故事虽然增强了华夏文明的凝聚力,却几乎让天文学停滞了,谁敢研究五大行星(在伽利略的望远镜发明之前,太阳系内是看不到天王星的)的运动规律呢?

说到五大行星,中西方惯称的顺序并不一致。中国常讲的顺序是金、木、水、火、土,不提它的阴阳五行之说,这个顺序与肉眼观测的亮度是一致的。它们的视星等分别是金星-4.6、木星-2.9、水星-1.9、火星-2.0、土星0.6,亮度依次变低(水星、火星差不多)。而古希腊称呼它们的顺序则是水星Mercury、金星Venus、火星Mars、木星Jupiter、土星Saturn,这与它们在天空中由快至慢的移动速度是相符的,也与它们到太阳的距离相关。从这点差异就能看出,古希腊的天文学成就有多领先其他文明!